[點晴模切ERP][轉帖]數據遷移工具,用這8種!

當前位置:點晴教程→點晴ERP企業管理信息系統

→『 經驗分享&操作答疑 』

:數據遷移工具,用這8種! :數據遷移工具,用這8種! 數據遷移工具,用這8種!前言最近有些小伙伴問我, ETL(是Extract-Transform-Load的縮寫,即數據抽取、轉換、裝載的過程),對于企業應用來說,我們經常會遇到各種數據的處理、轉換、遷移的場景。 今天特地給大家匯總了一些目前市面上比較常用的 1.Kettle

Kettle 中有兩種腳本文件,transformation 和 job,transformation 完成針對數據的基礎轉換,job 則完成整個工作流的控制。 Kettle 中文名稱叫水壺,該項目的主程序員 MATT 希望把各種數據放到一個壺里,然后以一種指定的格式流出。 Kettle 這個 ETL 工具集,它允許你管理來自不同數據庫的數據,通過提供一個圖形化的用戶環境來描述你想做什么,而不是你想怎么做。

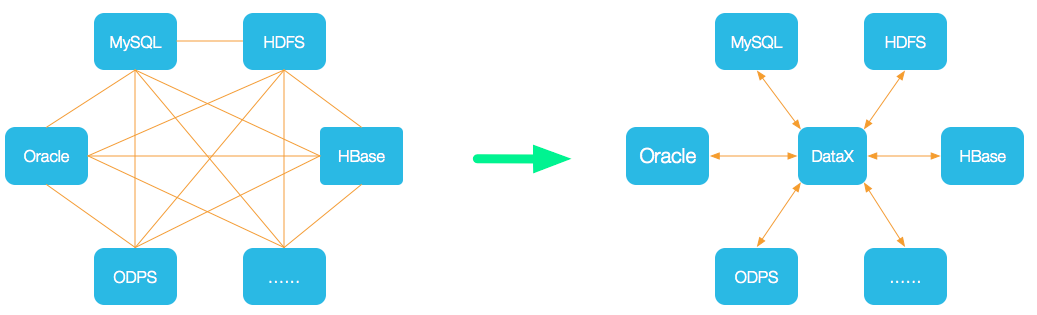

2.Datax

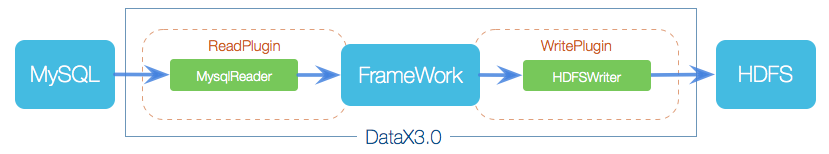

DataX 是一個異構數據源離線同步工具,致力于實現包括關系型數據庫(MySQL、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等各種異構數據源之間穩定高效的數據同步功能。  設計理念:為了解決異構數據源同步問題,DataX將復雜的網狀的同步鏈路變成了星型數據鏈路,DataX作為中間傳輸載體負責連接各種數據源。當需要接入一個新的數據源的時候,只需要將此數據源對接到DataX,便能跟已有的數據源做到無縫數據同步。 當前使用現狀:DataX在阿里巴巴集團內被廣泛使用,承擔了所有大數據的離線同步業務,并已持續穩定運行了6年之久。目前每天完成同步8w多道作業,每日傳輸數據量超過300TB。 DataX本身作為離線數據同步框架,采用Framework + plugin架構構建。將數據源讀取和寫入抽象成為Reader/Writer插件,納入到整個同步框架中。  DataX 3.0 開源版本支持單機多線程模式完成同步作業運行,本小節按一個DataX作業生命周期的時序圖,從整體架構設計非常簡要說明DataX各個模塊相互關系。

3.DataPipeline

可實現 Oracle、IBM DB2、MySQL、MS SQL Server、PostgreSQL、GoldenDB、TDSQL、OceanBase 等數據庫準確的增量數據獲取。 平臺具備“數據全、傳輸快、強協同、更敏捷、極穩定、易維護”六大特性。 在支持傳統關系型數據庫的基礎上,對大數據平臺、國產數據庫、云原生數據庫、API 及對象存儲也提供廣泛的支持,并在不斷擴展。 DataPipeline 數據融合產品致力于為用戶提供企業級數據融合解決方案,為用戶提供統一平臺同時管理異構數據節點實時同步與批量數據處理任務,在未來還將提供對實時流計算的支持。 采用分布式集群化部署方式,可水平垂直線性擴展的,保證數據流轉穩定高效,讓客戶專注數據價值釋放。

4.TalendTalend (踏藍) 是第一家針對的數據集成工具市場的 ETL (數據的提取 Extract、傳輸 Transform、載入 Load) 開源軟件供應商。

5.DataStageDataStage,即IBM WebSphere DataStage,是一套專門對多種操作數據源的數據抽取、轉換和維護過程進行簡化和自動化,并將其輸入數據集市或數據倉庫目標數據庫的集成工具,可以從多個不同的業務系統中,從多個平臺的數據源中抽取數據,完成轉換和清洗,裝載到各種系統里面。 其中每步都可以在圖形化工具里完成,同樣可以靈活地被外部系統調度,提供專門的設計工具來設計轉換規則和清洗規則等,實現了增量抽取、任務調度等多種復雜而實用的功能。其中簡單的數據轉換可以通過在界面上拖拉操作和調用一些 DataStage 預定義轉換函數來實現,復雜轉換可以通過編寫腳本或結合其他語言的擴展來實現,并且 DataStage 提供調試環境,可以極大提高開發和調試抽取、轉換程序的效率。 Datastage 操作界面

Datastage 包含四大部件:

6.SqoopSqoop 是 Cloudera 公司創造的一個數據同步工具,現在已經完全開源了。 目前已經是 hadoop 生態環境中數據遷移的首選 Sqoop 是一個用來將 Hadoop 和關系型數據庫中的數據相互轉移的工具,可以將一個關系型數據庫(例如 :MySQL ,Oracle ,Postgres 等)中的數據導入到 Hadoop 的 HDFS 中,也可以將 HDFS 的數據導入到關系型數據庫中。

同時也可以將 hadoop 生態集群中的數據導回到傳統的關系型數據庫 | 文件型數據庫 | 企業數據倉庫中。 那么 Sqoop 如何抽取數據呢?

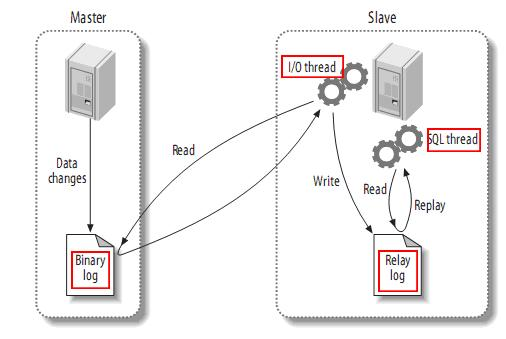

7.FineDataLinkFineDataLink是國內做的比較好的ETL工具,FineDataLink是一站式的數據處理平臺,具備高效的數據同步功能,可以實現實時數據傳輸、數據調度、數據治理等各類復雜組合場景的能力,提供數據匯聚、研發、治理等功能。 FDL擁有低代碼優勢,通過簡單的拖拽交互就能實現ETL全流程。 8.canalcanal [kə'næl],譯意為水道/管道/溝渠,主要用途是基于 MySQL 數據庫增量日志解析,提供增量數據訂閱和消費。 基于日志增量訂閱和消費的業務包括:

當前的 canal 支持源端 MySQL 版本包括 5.1.x , 5.5.x , 5.6.x , 5.7.x , 8.0.x。

canal 工作原理:

點晴模切ERP更多信息:http://moqie.clicksun.cn,聯系電話:4001861886 該文章在 2023/7/28 16:54:11 編輯過 |

關鍵字查詢

相關文章

正在查詢... |